重磅消息!马斯克等千人呼吁暂停训练高级AI

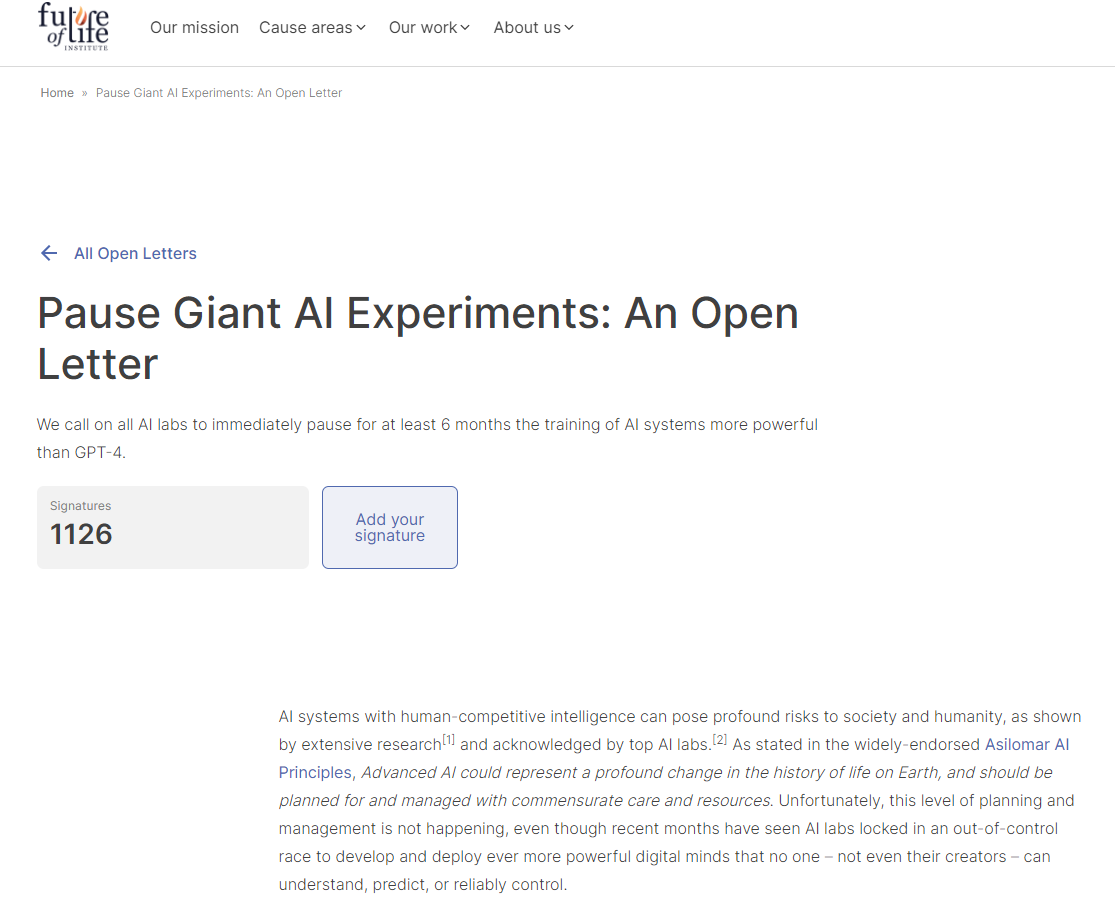

综合媒体报道称,未来生命研究所(Future of Life Institute)网站披露,该网站曾以公开信的方式发起倡议,呼吁所有AI(人工智能)实验室立即暂停训练比GPT-4更强大的AI系统至少6个月。

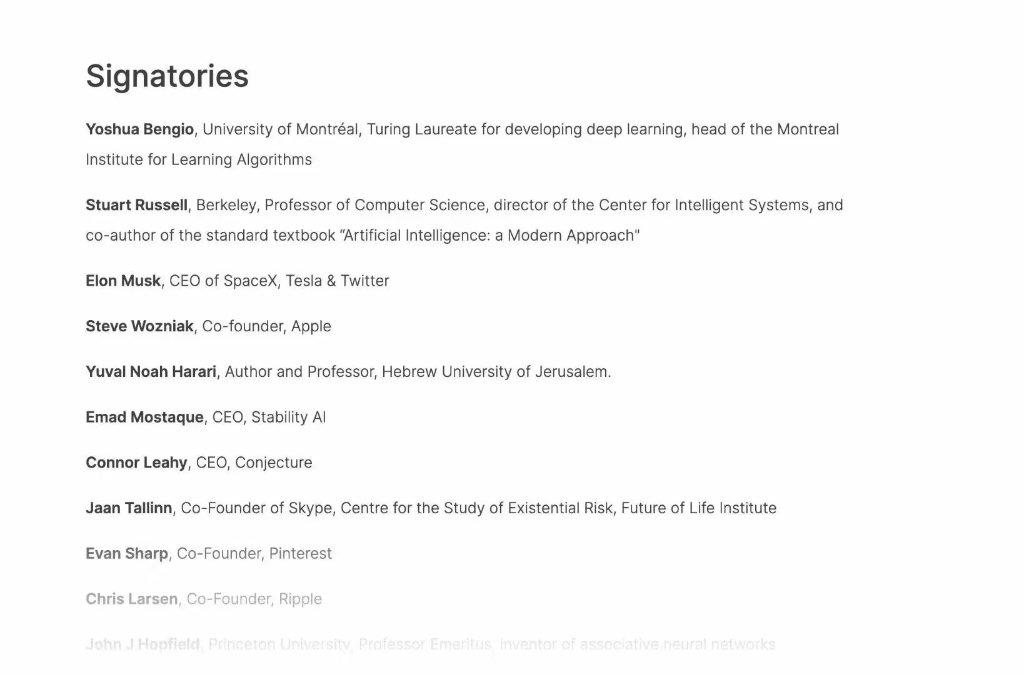

截至北京时间3月29日下午13时许,在该网站上,这封公开信获得了包括图灵奖得主Yoshua Bengio、马斯克、苹果联合创始人Steve Wozniak、Stability AI创始人Emad Mostaque等上千名科技大佬和AI专家已经签署公开信。

公开信认为,高级AI可能代表地球生命史上的深刻变化,人类应以相应的关怀和资源进行规划和管理——但不幸的是,对应级别的规划和管理并没有发生。此外,最近几个月AI实验室们陷入了一场失控的竞赛(an out-of-control race),但包括这些AI系统的创造者们,都无法完全去理解、预测或者可靠地控制(reliably control)它们。

公开信写道,广泛的研究表明,具有与人类竞争智能的人工智能系统可能对社会和人类构成深远的风险,这一观点得到了顶级人工智能实验室的承认。

公开信表示,人们只应在这样的背景下去开发强大的人工系统:确信它们的影响是积极的,确信它们的风险是可控的。信件还援引了OpenAI(ChatGPT的开发者)在其最新声明中的表态,“在某个时候,在开始训练未来的AI系统之前,对它进行独立审查可能很重要。”“现在就是那个时候。”公开信认为。

公开信呼吁,所有AI实验室立即暂停至少6个月的训练工作——对象是那些比GPT-4更强大的AI系统。公开信称,这种暂停应该是公开的和可验证的,并且包括所有关键参与者。如果不能迅速实施这样的暂停,政府应该介入并暂停。

“这并不意味着总体上暂停AI开发,”公开信表示,AI实验室和独立专家应该利用这次暂停,共同开发和实施一套用于高级AI设计和开发的共享安全协议,并由独立的外部专家进行严格审计和监督。此外,公开信还呼吁,AI开发人员必须与政策制定者合作,以显着加快开发强大的AI治理系统。

生命未来研究所什么机构?

这一幕似曾相识,当初谷歌在AI领域一骑绝尘,OpenAI的创始人Sam Altman为此举办了一个私人宴会,邀请了马斯克等一众科技圈大佬,最终在数月后成立了非营利组织OpenAI以遏制谷歌。如今,同样的情景竟然发生在自己身上了……

资料显示,生命未来研究所也是一个非营利组织,它创立于2014年3月,其创始团队主要是高校学者、学生,包括麻省理工学院宇宙学家马克斯·泰格马克,Skype联合创始人让·塔林等。

其研究所顾问委员会成员来源较广,部分名字耳熟能详,包括宇宙学家史蒂芬·霍金、特斯拉CEO埃隆·马斯克,亚伦·艾达、摩根·弗里曼等演艺界人士也在其中。

生命未来研究所关注包括AI、生物技术、核武器、气候变化在内的多个重大议题。从其官网简介来看,其主旨在于引导变革性技术造福生命,远离极端大规模风险。

该如何看待公开信?

对于这封公开信以及签署的大佬们,部分网友认为是“酸葡萄心理”。比如,“马斯克之所以会签署这份协议,是因为他想开发AI来赚钱”。

有网友称,马斯克他们这样呼吁能“以便他们有机会迎头赶上”。为何网友会这样认为?有分析指出,马斯克已与AI研究人员进行了接触,希望建立一个新的研究工作室,开发能替代ChatGPT的产品。

ChatGPT是由初创公司OpenAI开发的聊天机器人,因其强大的语言生成能力备受瞩目。自ChatGPT今年年初爆火后,马斯克——作为OpenAI最初的创始人之一(后因观念不同而分道扬镳)——开始在社交媒体上对其接连“开炮”,称人工智能将在未来造成极大的威胁。

马斯克作为OpenAI的创始人之一,2015年,他和其他几位硅谷大佬一起向OpenAI注资10亿美元。不过,马斯克于2018年离开OpenAI董事会,此后一直对该公司持批评态度,尤其是针对它与微软的关系。

也有网友认为这封公开信的担忧有一定的合理性。“这份名单上有许多非常聪明和受人尊敬的科学家,Omohundro、Bengio、Koch、Hopfield 等等。我不认为这个“精灵”(AI)可以放回瓶子里,但这让我停下来思考所有人都在担心。”

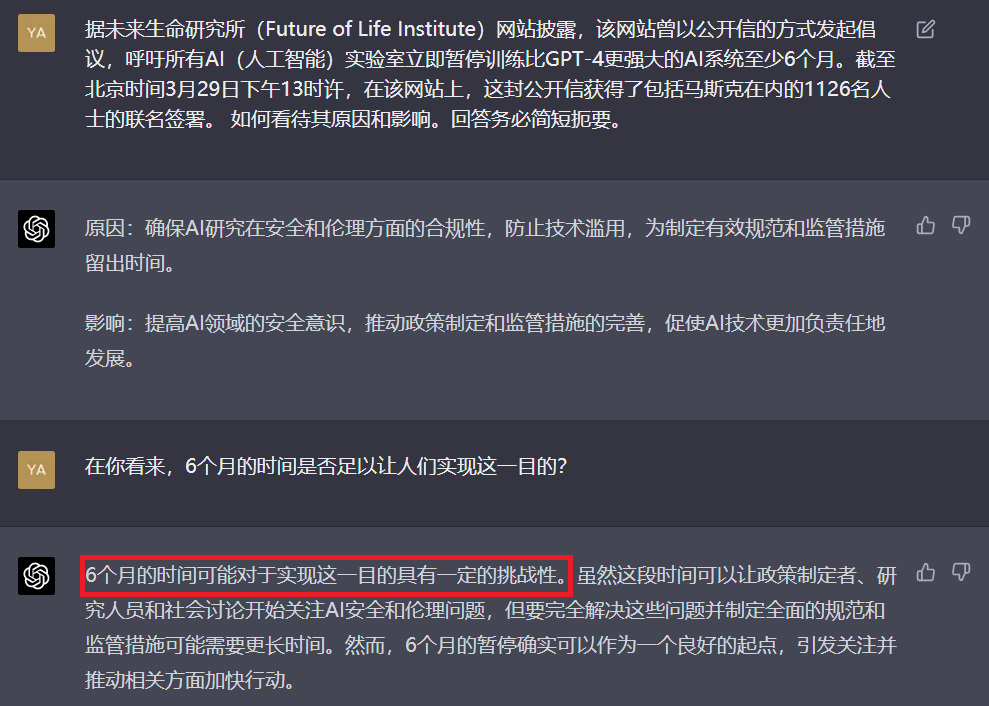

对于此事,“GPT-4怎么看”?ChatGPT在回答提问时表示,其原因为确保AI研究在安全和伦理方面的合规性,防止技术滥用,为制定有效规范和监管措施留出时间。

对于这一行动的影响,GPT-4称,这将提高AI领域的安全意识,推动政策制定和监管措施的完善,促使AI技术更加负责任地发展。

当被问道,“在你看来,6个月的时间是否足以让人们实现这一目的?”GPT-4认为,虽然这段时间可以让政策制定者、研究人员和社会讨论开始关注AI安全和伦理问题,但要完全解决这些问题并制定全面的规范和监管措施可能需要更长时间。

然而,6个月的暂停确实可以作为一个良好的起点,引发关注并推动相关方面加快行动。“6个月的时间可能对于实现这一目的具有一定的挑战性。”

AI背后不可忽视的风险

综合媒体早前报道,当地时间3月25日,OpenAI创始人兼首席执行官Sam Altman在接受科技博客主Lex Fridman的采访时表态,他不会回避“人工智能可能杀死全人类”的说法。

在Youtube平台公布的视频中,Fridman在访谈中提到了人工智能研究者、LessWrong研究所创始人Eliezer Yudkowsky的观点。Yudkowsky此前指出“人工智能可能杀死所有人”,并认为,当人工智能发展为超级智能时,几乎无法与人类站在统一战线上。、

对于此,Altman回应道,“我认为有这种可能性,并且承认这一点很重要,因为如果我们不谈论它、不把它视为潜在的事实,那么我们就不会投入足够的努力去解决这个问题。”

此外,史蒂芬·霍金曾警告说,全面化人工智能的发展可能意味着人类的终结。霍金写道,你可能不是出于恶意踩踏蚂蚁的邪恶仇恨者,但如果你负责一个水电绿色能源项目,并且有一个该地区的蚁丘被洪水淹没,对蚂蚁来说太糟糕了。我们不要将人类置于那些蚂蚁的位置。